の計算例

以下の設定で、センシティブ属性 { 男性、 女性} について計算する場合

- 男性 32000人、女性 48000人の候補者がいたとする

- ランク上位100人は、男性20人、女性80人であったとする

- 望ましい分布は、全候補者における割合に基づいて決めるものとする

※ 論文では と書きつつ で計算してしまっているので、値はずれています。

の弱点

- 属性ごとに求める値のため、すべてのセンシティブ属性で評価する必要がある

- 上位ランク数 に依存して決まる値のため、様々な で評価する必要がある

と

- 属性ごとに求める値のため、すべてのセンシティブ属性で評価する必要がある

- 上位ランク数 に依存して決まる値のため、様々な で評価する必要がある

すべての属性について調べて、最大・最小のものをとった指標を用いればよい

- 属性ごとに求める値のため、すべてのセンシティブ属性で評価する必要がある

- 上位ランク数 に依存して決まる値のため、様々な で評価する必要がある

順位についても重み付きの平均を取れば良い. これは、検索タスクにおいて知られている公平性を評価する指標の1つである $NDKL$ となる

- : ランキング結果の上位のなかで、各属性を持っている確率の分布

- : 望ましい分布

- : KL-divergence ( を属性について重み付きで平均したもの)

FAIRNESS-AWARE RANKING ALGORITHMS

ランキングアルゴリズムに求められる性質

- ランキング結果の分布 を、可能な限り望ましい分布 に近づけたい

- 検索・推薦タスクにおいては、が大きい場合ではなく少ない場合が特に重要

InfeasibleIndex

下記の 2. を満たさない時に、ランキング結果がinfeasibleであると呼ぶことにする.

-

- : 属性 を持つ候補者の数

infeasibleとなる属性 が存在する上位ランク数 の数を InfeasibleIndex とする

DetGreedy

貪欲に公平性を満たすものを採用していくアルゴリズム

- を超えない属性の候補について、スコアの高い順に採用していく

- Infeasible な属性があった場合は、その属性の中で最もスコアの高いものを採用する

DetCons and DetRelaxed

DetCons

- スコアではなく、infeasibleとなりやすい属性の候補を採用

DetRelaxed

- infeasibleとなりやすい属性の候補の中で、スコアの高いものを採用

DetConstSort

公平性の制約を破らない範囲で、できるだけスコアの高いものが上位にくるように並べ替えを行う

Evaluation and Deployment in Practice

シミュレーション

以下のフレームワークでシミュレーションを行い、提案手法を評価

- として、各 毎に 2. 以降を繰り返す

- 100Kの次元の多項分布 を準備

- 各出現確率は一様分布からサンプリングして、和が1となるよう正規化

- 各 毎に、以下を繰り返す

- 各属性ごとに100個の候補をランダムに生成し、ランダムなスコアを付与

- スコアに基づいてソート

- を望ましい分布として、提案手法を適用し、上位100位までのリストを得る

- 前述の指標を用いて評価

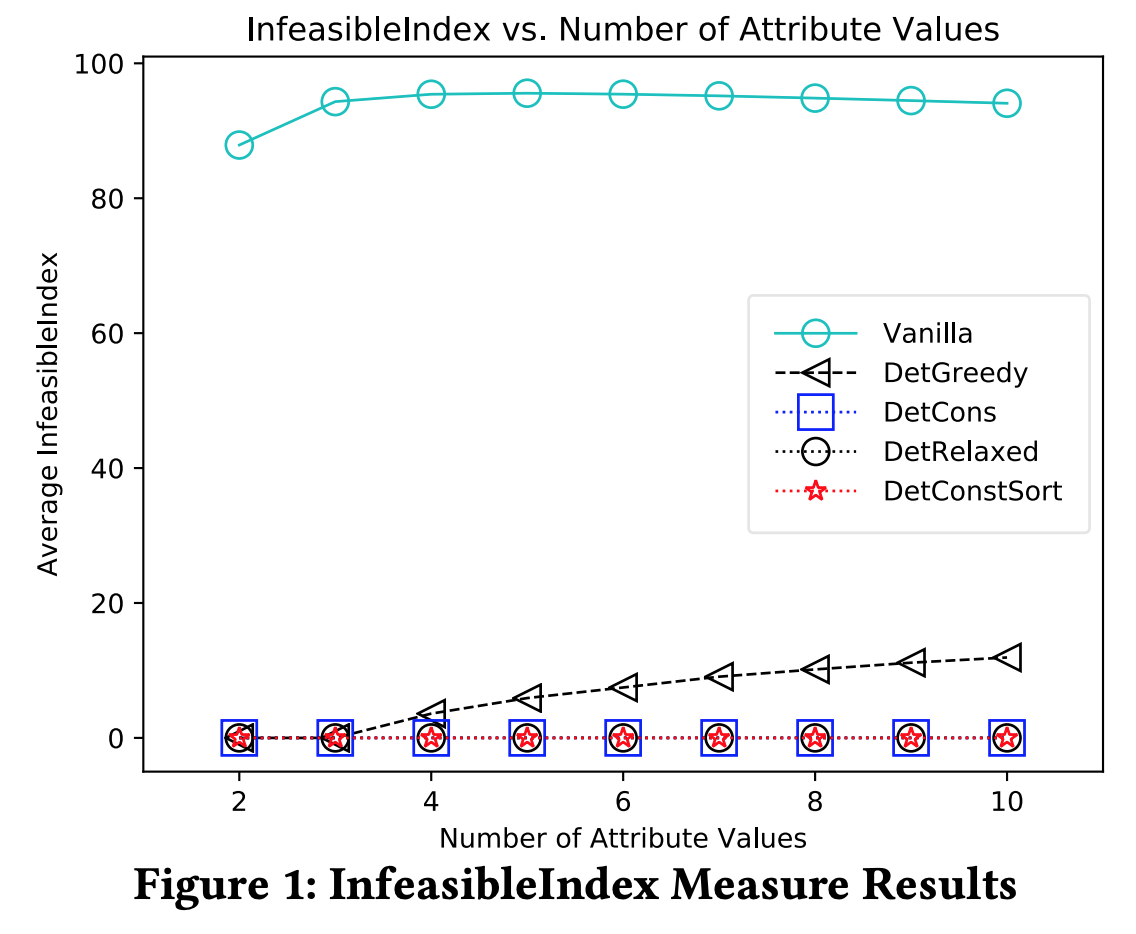

シミュレーション結果: InfeasibleIndex

- DetGreedy では、 において、Infeasible な状況が発生している

- それ以外のアルゴリズムは、全て feasible となっている

- これは理論的な保証がある

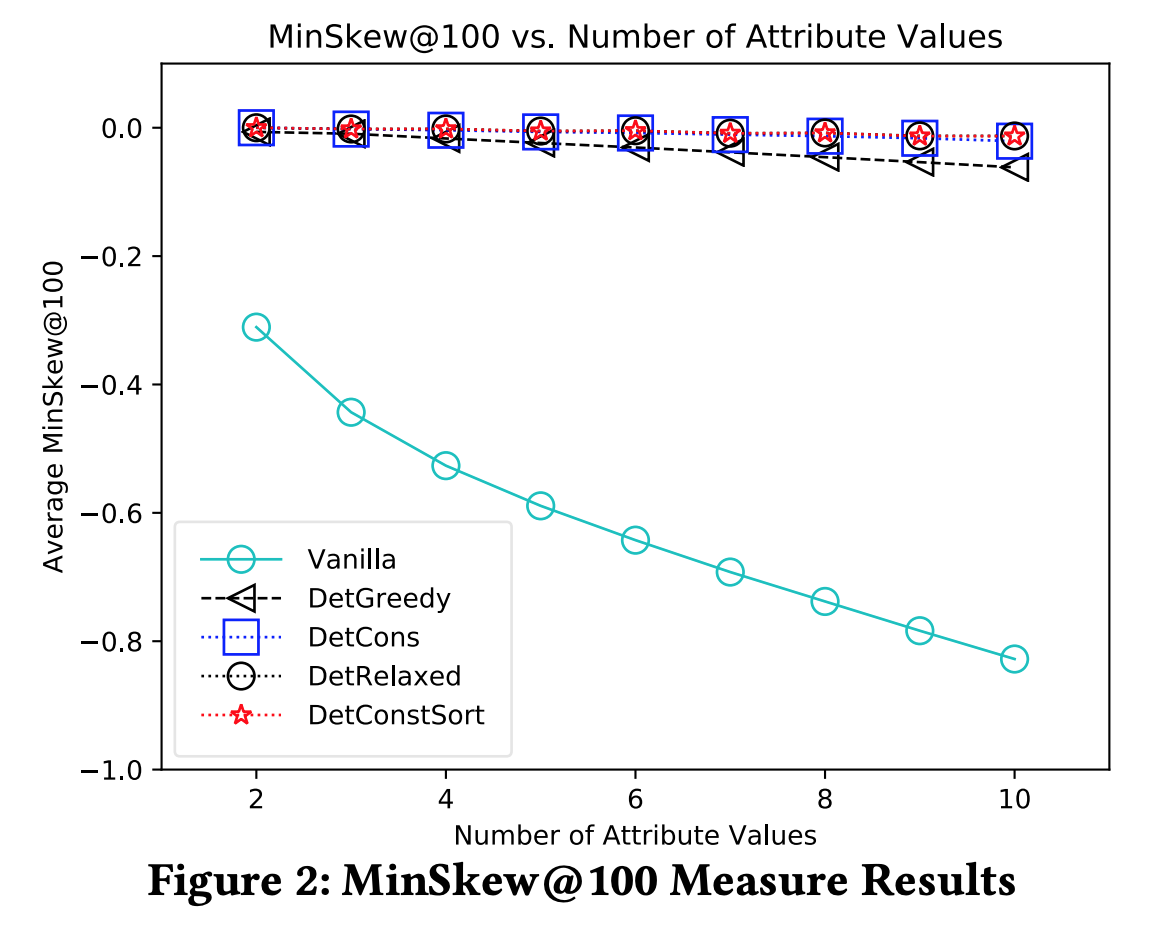

シミュレーション結果: MinSkew

- DetGreedyは MinSkew が若干下がる傾向がある

- グラフはないが、 MaxSkew も同様の傾向がある

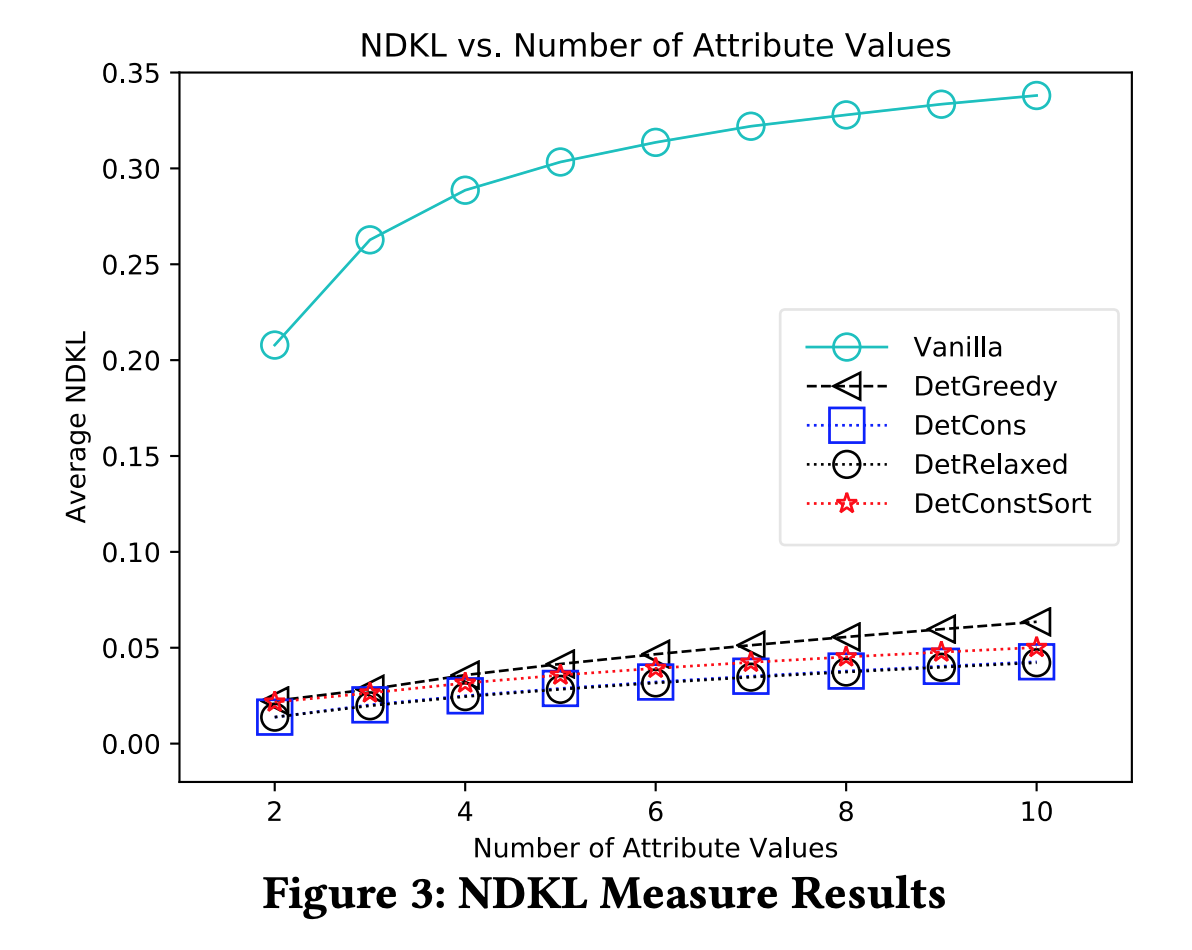

シミュレーション結果: NDKL

- DetConsやDetRelaxedがDetConstSortよりも若干良い傾向がある

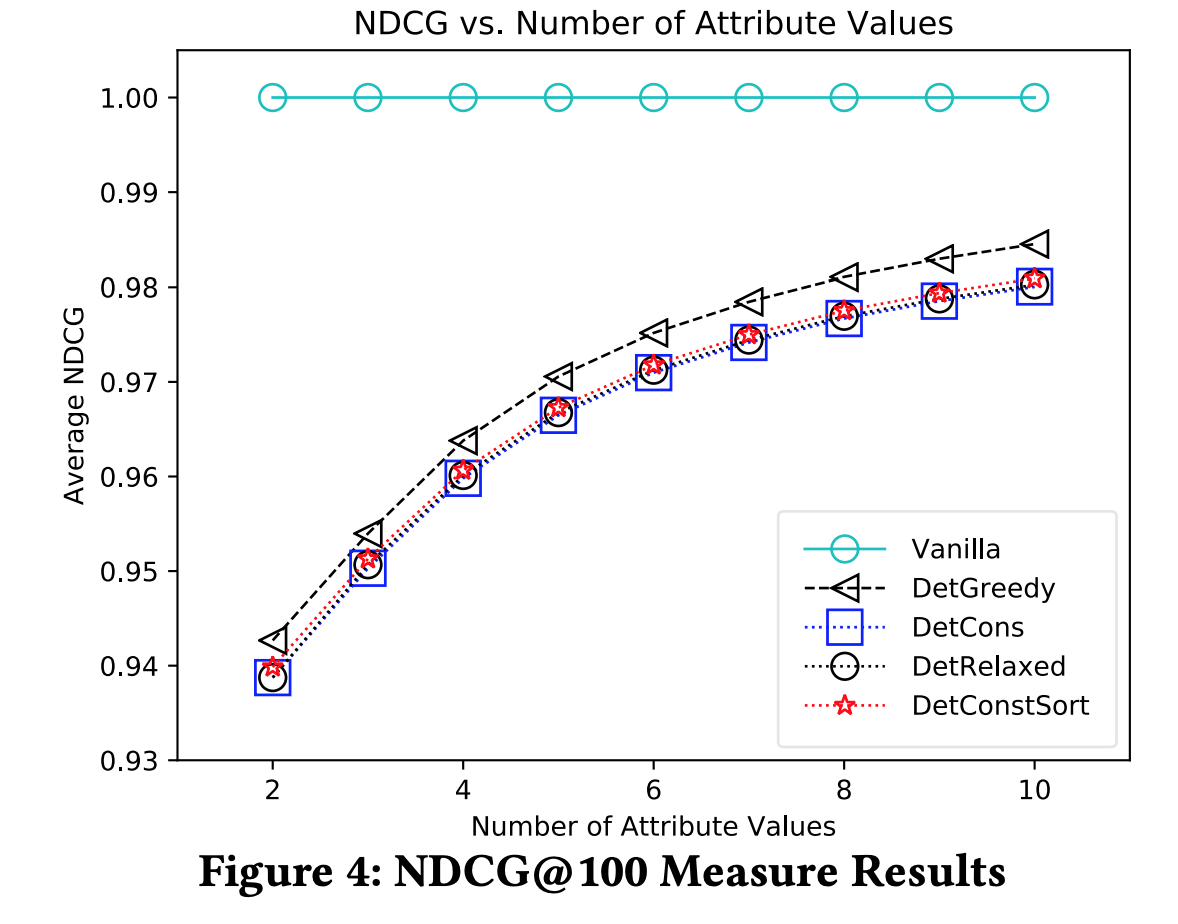

シミュレーション結果: NDCG

- 公平性の指標ではなく、性能に関する評価指標(公平性を考慮したことによる性能劣化の指標)

- は関連度で、今回はスコア

- NDCGは、他の手法と比較して、DetGreedy が若干良い傾向がある

シミュレーション結果: まとめ

- DetGreedyは( で公平性の制約を満たす理論的保証がないにもかかわらず)概ね良好な結果となった

- DetCons、DetRelaxed、 DetConstSort については、公平性の指標という観点では大きな違いはなく、どれがベストだとは言い切れない

- A/Bテストなどによってパフォーマンスを評価し、適切なものを選べばよい

A/B テストの概要

LinkedIn Talent Search で A/B テストを実施

- Talent Search はリクルータや、採用マネージャーが候補者を検索できるサービス

- 対処とするセンシティブ属性は性別

- 検索基準を満たす候補全体の性別の分布を、望ましい分布として利用

- 機会均等の達成に相当

- シミュレーションの結果と実装のシンプルさから、DetGreedy を利用

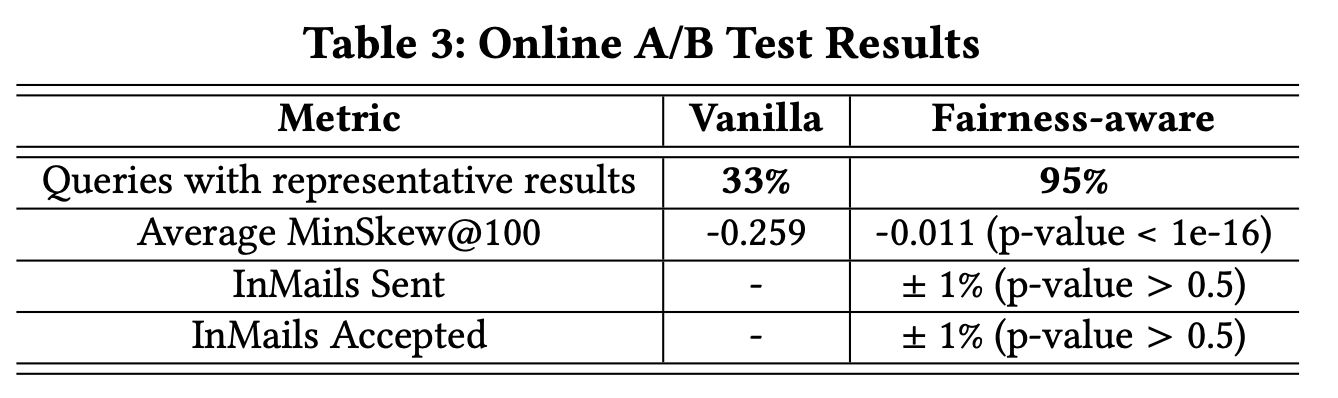

A/B テストの結果

- 既存のアルゴリズムでは、公平性の制約を満たすクエリの割合が 33% だったのに対し、提案手法を採用することで、95%まで向上した

- InMails Sent や InMails Accepted といった、ビジネス指標について、既存のアルゴリズムだけを用いた場合と有意な差は見られなかった

得られた示唆など

- Post-Processing による公平性の担保のメリット

- Pre-Processing や In-Processing では、モデル依存の実装にならざるを得ないが、Post-Processingであれば、モデルを選ばない

- 現実のシステムでは、機械学習モデルの後処理としてドメイン固有のロジックが組み込まれることが多いため、できるだけパイプラインの最後に、公平性を担保する処理を組み込む必要がある

- 既存のシステムへの組み込みが容易

- 望ましい分布を、倫理的、社会的、法的な観点などから決定する必要がある

- 望ましい分布は自由に選べるので、いろいろな定義の「公平性」に対応できる

- 望ましい分布、という概念の説明のしやすさ

- ステークホルダーが多くなりがちなので、思想の説明のしやすさは重要

まとめ

- 検索や推薦システムで用いられるランキングタスクにおいて、機械学習によってスコアリングされた候補リストを、公平性の制約を満たすように再ランク付けするアルゴリズムを提案

- 公平性の要件を「望ましい分布」を提示することで与える

- 機会均等や人口統計学的パリティなど、いろいろな公平性の基準に利用可能

- 大規模なシミュレーションと A/B テストにより、提案手法を評価

- ビジネスメトリクスに統計的に有意な変化を与えることなく、公平性の大幅な改善をもたらした

参考文献

- 福地 一斗, 公平性に配慮した学習とその理論的課題, IBIS2018.

- Julia Angwin; Jeff Larson; Surya Mattu; Lauren Kirchner, Machine Bias, ProPublica.

- Ninareh Mehrabi; Fred Morstatter; Nripsuta Saxena; Kristina Lerman; Aram Galstyan. A Survey on Bias and Fairness in Machine Learning, arXiv:1908.09635.

- Fairness入門, AI-SCHOLAR.